在自动驾驶技术日新月异的今天,我们正站在一个关键的十字路口。从早期模块化的“感知-定位-规划-控制”系统,到特斯拉引领的端到端(E2E)学习,再到如今融合了视觉、语言和动作(VLA)的具身智能趋势,每一次范式转变都预示着自动驾驶能力的巨大飞跃。

本文将深入探讨这些演进路径,剖析它们各自的优势与挑战,并展望VLA模型如何引领我们迈向更安全、更通用、更人性化的智能驾驶未来。

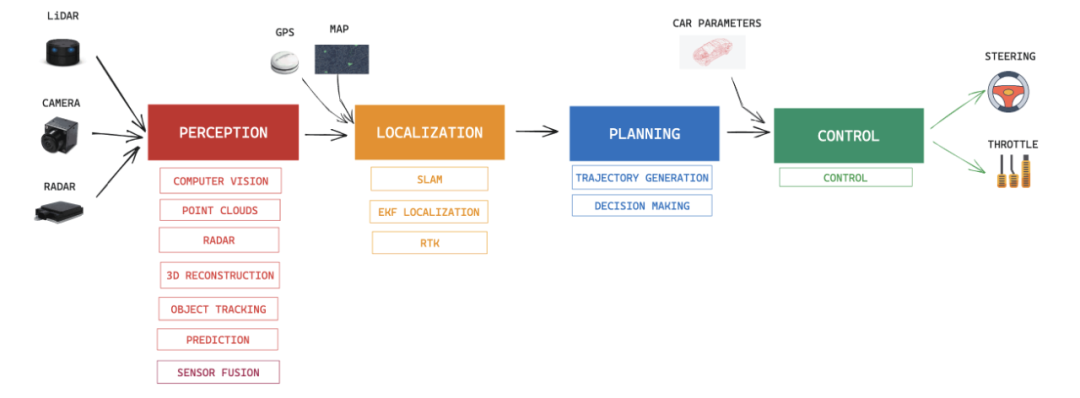

基本是模块化设计,分成了感知、定位、规划、控制四大块。这就像搭积木,每个模块都有自己的活儿,目的就是让自动驾驶这事儿好落地,也就是Rule based(基于规则)时代。大家写规则、验证模块,一切看起来井井有条。

但问题也来了:感知、预测和规划这些模块之间,很容易出现误差累积和信息丢失。

最经典的模块化例子就是通用的Super Cruise。它用CNN视觉算法识别车道线、物体,再结合高精地图和RTK定位,最后融合起来做路径规划和控制,实现了智能驾驶。

中国新势力们的“Pilot”一代,像2019年蔚来的 NIO Pilot和小鹏的 XPilot,都属于这种。直到现在,大部分高速领航辅助还是这个路子,毕竟方案成熟,性价比高。

当时,像 Mobileye和英伟达 Xavier这些只有几到30TOPS算力的小芯片,就已经撑起了智驾行业的一片天。

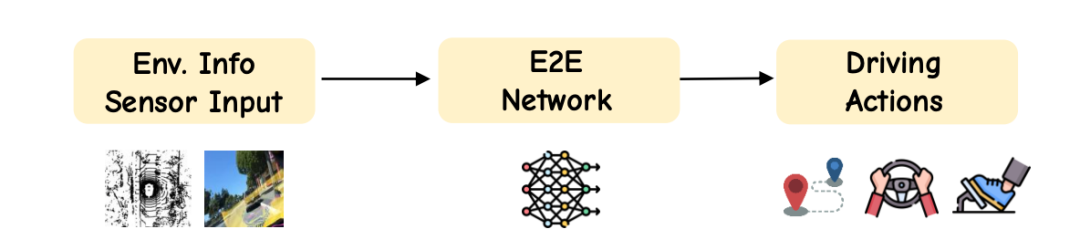

2.端到端(E2E):特斯拉开创的新纪元端到端(E2E)驾驶策略彻底颠覆了传统。它直接把原始传感器数据映射到控制指令,跳过了那些手工编写的规则代码和模块化流程。

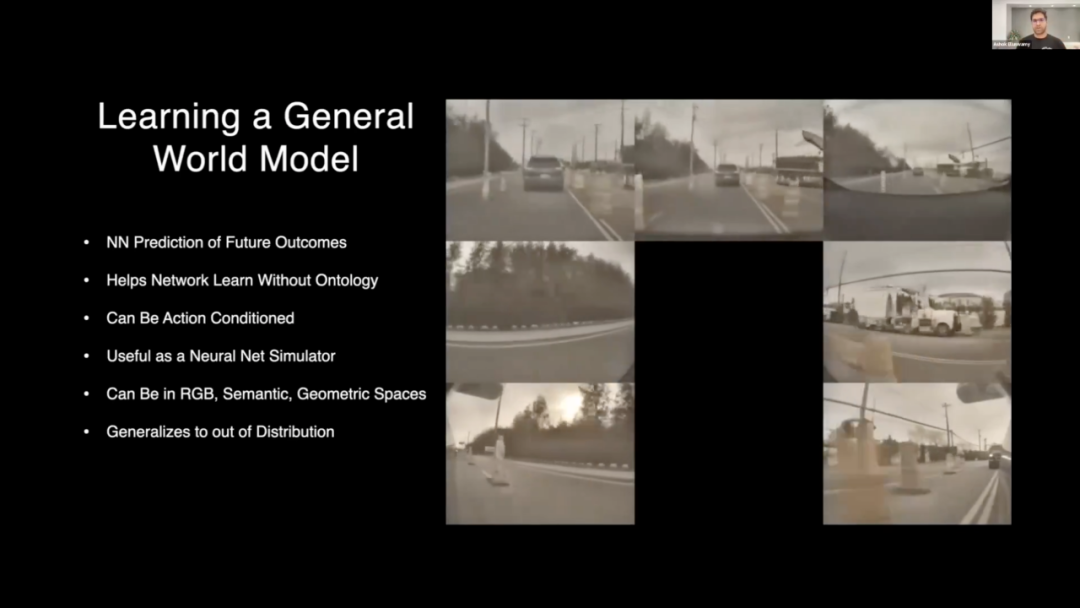

E2E本质上是个视觉到行动(VA)系统。视觉输入可以来自摄像头或激光雷达,行动输出通常是未来的轨迹或控制信号。特斯拉FSD就是E2E的典型代表。它通过BEV(鸟瞰图)和Occ(占用网络)等技术,联合时空一体的端到端大模型,打通了从视觉到执行的链条,形成了数据闭环。有了影子数据配合General World Model(通用世界模型)生成数据,实现了E2E大模型的闭环训练和算法迭代。

不过,从2023年起,特斯拉就不再公开FSD的算法结构了。所以现在FSD到底怎么搞的,我们只能靠猜,或者少数业内人士才清楚。在国内,随着2024年智能驾驶开始“进城”,无穷无尽的复杂场景让规则化设计忙不过来了。这时,英伟达的256TOPS Orin X大算力芯片及时送来“神助攻”,行业开始转向特斯拉那种更集成的端到端方案。把感知、预测、规划模块整合到一个统一框架里,主要是为了促进跨模块的特征级信息流,确保数据高效闭环。但学术界发现,传统E2E算法在训练数据超过一定量后,收益会递减,而且不同场景类型下的性能差异很大。

这些表明,光靠数据堆砌,不足以实现L4级以上的自动驾驶能力。总的来说,端到端学习确实大大缩短了原始传感器输入到控制决策的距离,但仍有两大持续挑战:语义脆弱:对人类世界的语言和符号信息(比如路牌、警笛声),在罕见或快速变化的场景下容易失效。推理不透明:可解释性差,很难进行安全审计和验证。模型升级后,只能通过一次次模型刷机、试驾才能知道有没有回退,有没有效果。

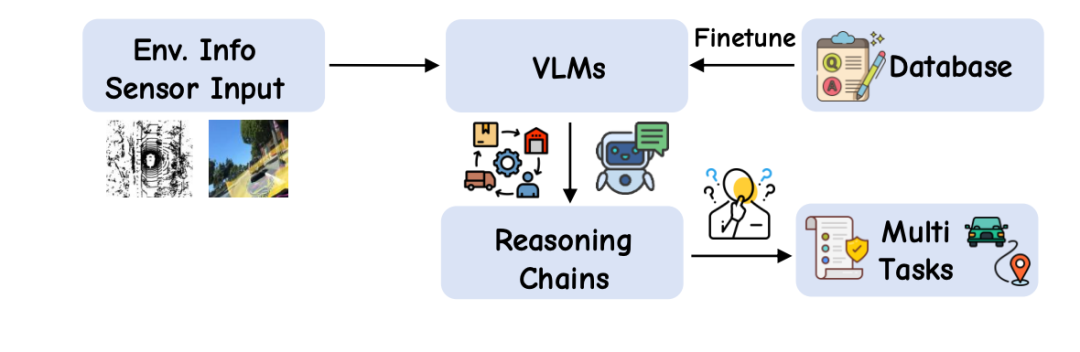

3.VLM:当大语言模型遇见自动驾驶2022年底,OpenAI开启的GPT时代让我们瞬间见识了大语言模型(LLM)的强大,当时LLM就像核武器一样高端不可及。但到了2024、2025年,Meta的LLaMA、深度求索的Deepseek、阿里的Qwen等大量开源多模态LLM出现,让大家心里痒痒,跃跃欲试想把它引入汽车智驾行业。LLM和VLM(视觉语言模型)通过在共享嵌入空间内统一感知和自然语言推理,提供了一种有希望的解决方案。

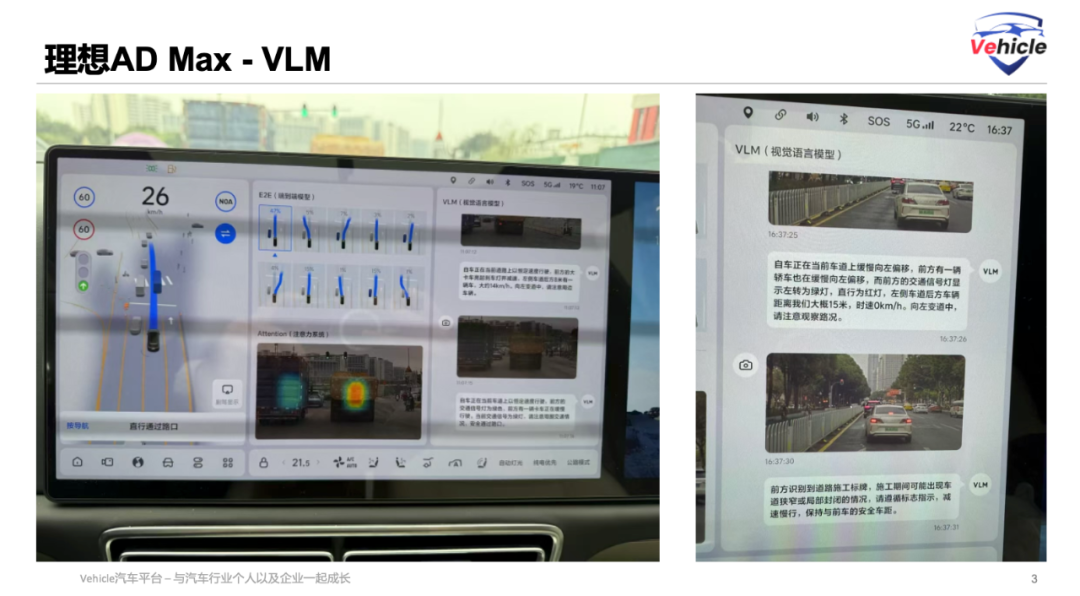

所以,把语言模式和驾驶任务结合起来,为增强自动驾驶系统的感知推理能力、可解释性和泛化能力,提供了新的方向。这其中的核心是大规模多模态预训练。它能让模型获得常识性关联(比如,看到文字标牌/路口就该减速;听到警笛就该让;看到潮汐车道/公交车道就知道何时能进何时不能进等),而传统的E2E任务标签往往会忽略这些。虽然大型基础模型对常识推理和极端情况理解很有用,但把它集成到驾驶系统也有缺点:空间感知能力差、数值输出模糊,以及规划延迟增加。学术界有很多论文研究用VLM来增强E2E智能驾驶,但产业界目前只有理想汽车进行了落地探索。理想采用了双系统架构,把知识蒸馏后的离线VLM作为“慢系统”,给“快系统”端到端系统提供反馈或辅助信号。

毕竟,两块加起来才504TOPS的Orin X芯片,跑这类大语言模型还是有点吃力,即使是蒸馏缩小后的。

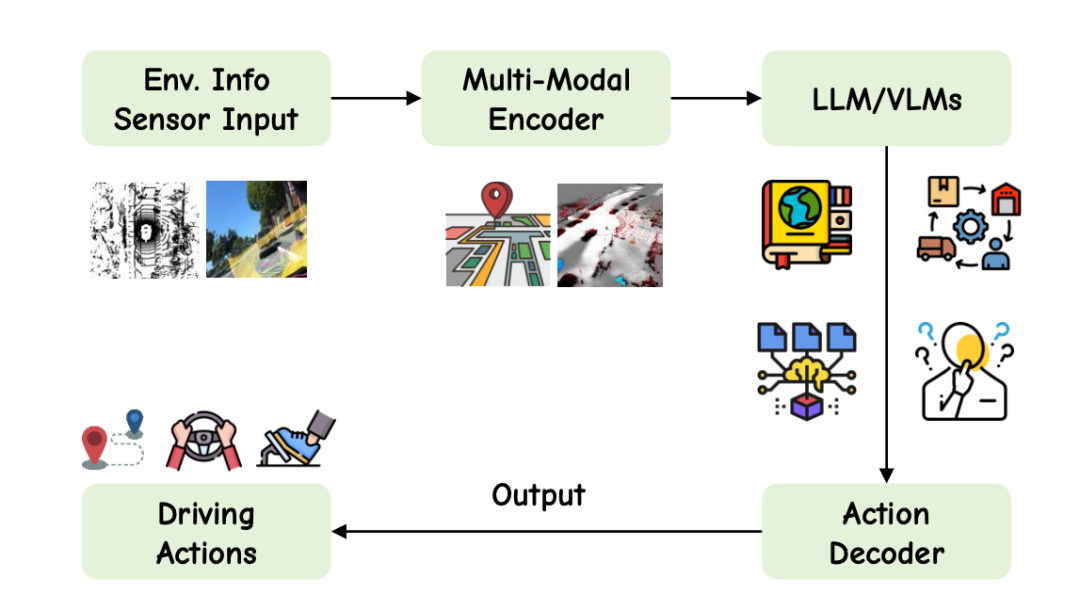

的发展,具身智能机器人产品不像汽车那样对安全敏感,各种实验机会推动了机器人产业的蓬勃发展。而将视觉、语言和动作统一在一个框架内,已经成为具身智能机器人领域的一个趋势。同样是应用于人类物理世界的AI,汽车产业自然也受到了具身智能最新进展的启发开始采用VLA(视觉-语言-动作)。

VLA利用在互联网规模的视觉和语言数据上预训练的基础模型,在各个领域和基准上都展现出强大的泛化能力。此外,VLA还联合推理视觉、语言和动作,融合了文本和轨迹输出、长视域记忆、符号安全检查以及多模态扩散规划,开启了VLA的新范式。更重要的是,VLA支持语言(指令/问答)交互,也就是说,它真的有可能实现把自动驾驶当作你的专属“司机师傅”:直接导航命令:“在下一个路口左转”、“停在红色车辆后面”,能听懂基本指令。

随着系统成熟,用户或代理可以提问:“现在变道安全吗?”或者“这里的限速是多少?”实现了交互式态势感知,环境查询变得可能。进一步的进展引入了任务级语言规范,比如解释交通规则、解析高级目标,或者理解自然语言表达的地图约束。甚至可以转向多轮对话、推理链(比如,思路链提示)。还可以采用工具增强的语言界面,支持更丰富的推理形式,并与人类的决策过程保持一致。当然,目前这些VLA语言交互都还只是实验室理论成功项目,绝大部分都还没有量产。

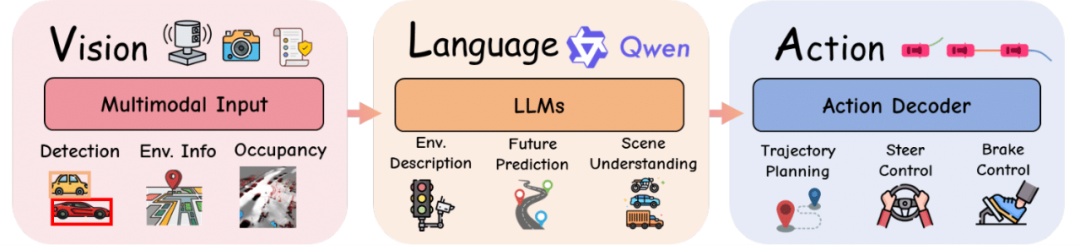

但这些进步,代表着从以感知为中心的VLM流程,向行动感知、可解释、指令遵循的多模态代理VLA的决定性转变,为更安全、更通用、更人性化的自动驾驶铺平了道路。2025年,英伟达的下一代边缘算力芯片Thor,几经推迟后,终于有一块720TOPS的Thor U有望推出,它将能跑VLA!瞬间点燃了2025年中国汽车VLA的落地战役。当然,目前理想、小鹏、元戎等明确表示将量产,但都处于非常早期。VLA的技术细节主要有三大核心模块:视觉编码器:采用自监督模型如DINOv2、CLIP,结合BEV投影和LiDAR融合技术。语言处理器:大语言模型(如LLaMA、Qwen、Vicuna、GPT等),通常通过LoRA等轻量化技术优化。动作解码器:包括自回归token、扩散规划器、分层控制器(高层策略PID/MPC控制)。

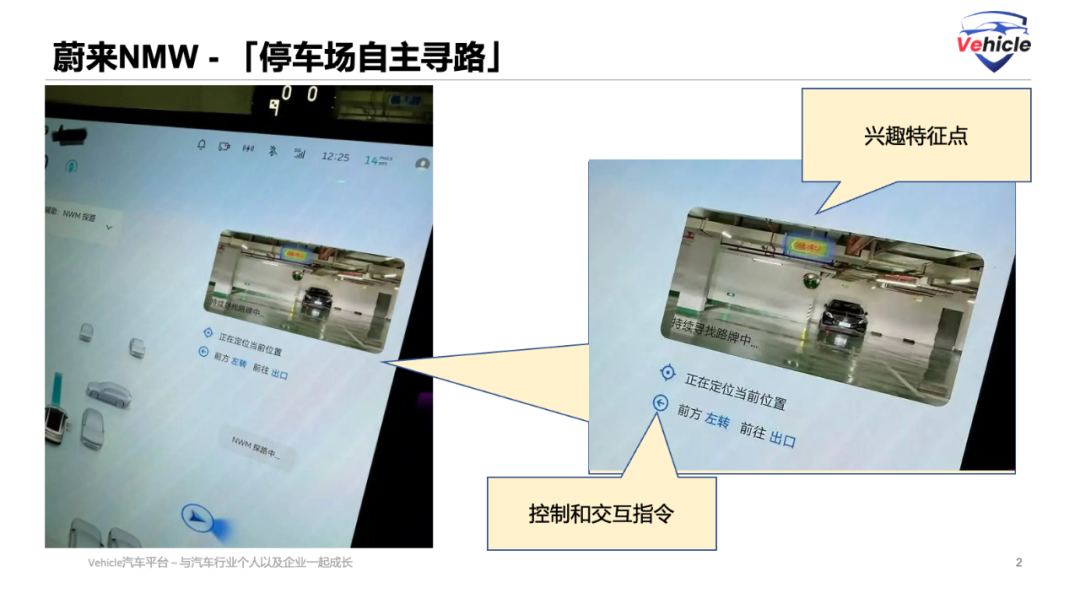

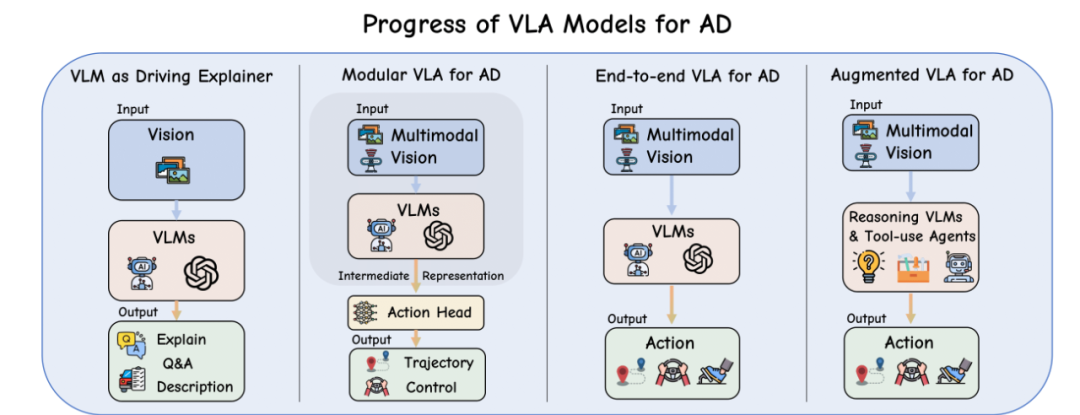

VLA在智能驾驶应用方面仍非常早期。学术界将VLA模型在智驾方面的发展归纳为四个主要阶段:Pre-VLA:语言作为解释器LLM解码器用自然语言解释驾驶场景或推荐操作,但实际车辆控制还是由传统模块(PID控制器等)处理。无需直接输出控制。例如,它会拍一张前置摄像头图像,生成文本描述或高级操作标签(“减速”、“左转”),然后输入给车辆控制。所以,它叫Pre-VLA。目前蔚来汽车的NWM(世界模型)有点类似,其“停车场自主寻路”功能就采用了类似方案:前摄像头在停车场寻找箭头指示牌,生成标签,车控接收并执行。

模块化VLA:语言模型从被动的场景描述者,变成了模块化架构中主动的规划组件,有点像国内发明的两段式端到端概念:VLM + Action,Action是拆开的。例如采用混合专家架构,如“超车专家”或“走走停停专家”,利用语言提示根据上下文动态选择子规划器。理想汽车宣传的VLA“语言控制MoE”等概念,似乎也类似此类。统一端到端VLA(如EMMA):单一网络直接映射多模态输入到控制或轨迹输出,国内叫法可以称为一段式VLA。Waymo的EMMA应该是统一的端到端VLA,它将多模态数据(视觉、激光雷达甚至4D毫米波雷达)统一输入,联合执行物体检测和运动规划。但学术界也指出,端到端VLA的局限在于长程推理和复杂多步规划能力有限。推理增强型VLA:语言模型处于控制闭环的核心,同时支持长时记忆和链式推理。这样它能在输出动作之前进行解释、预测并执行长远推理,真正实现代理司机的概念。

目前汽车自动驾驶产业界,小鹏提起了类似VLA能力,但根据发布信息,这应该是“期货”、实验室和广告信息,上车不会早于明年初。毕竟,长推理、带记忆的VLA面临两大问题:车载大算力需求和CoT(思考链)推理延迟。

关注智能驾驶算法软件发展的朋友,可能还听过两个热词:“基础模型(FM)”和“世界模型(WM)”。

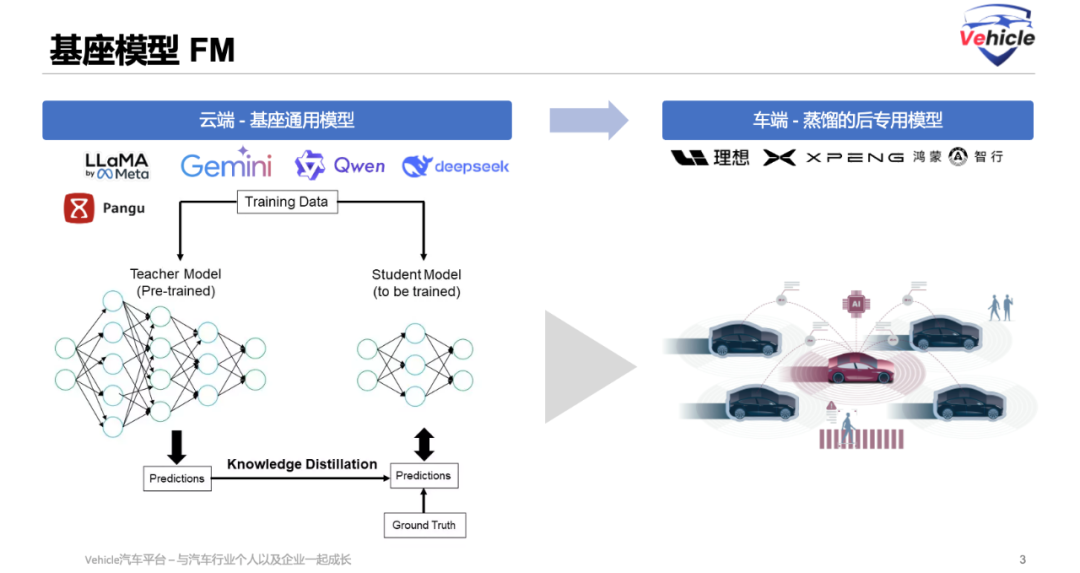

基础模型,你可以理解为VLA模型中多模态感知推理模块的“母模型”。它最原始是在云端训练,基本都是科技大厂的东西,汽车行业应用都是在此基础上进行微调和特殊化训练。例如,现在小鹏和理想的基座模型基本都采用了阿里的通义千问。

具体,可以看三图看懂自动驾驶基础模型 Foundation Models这篇

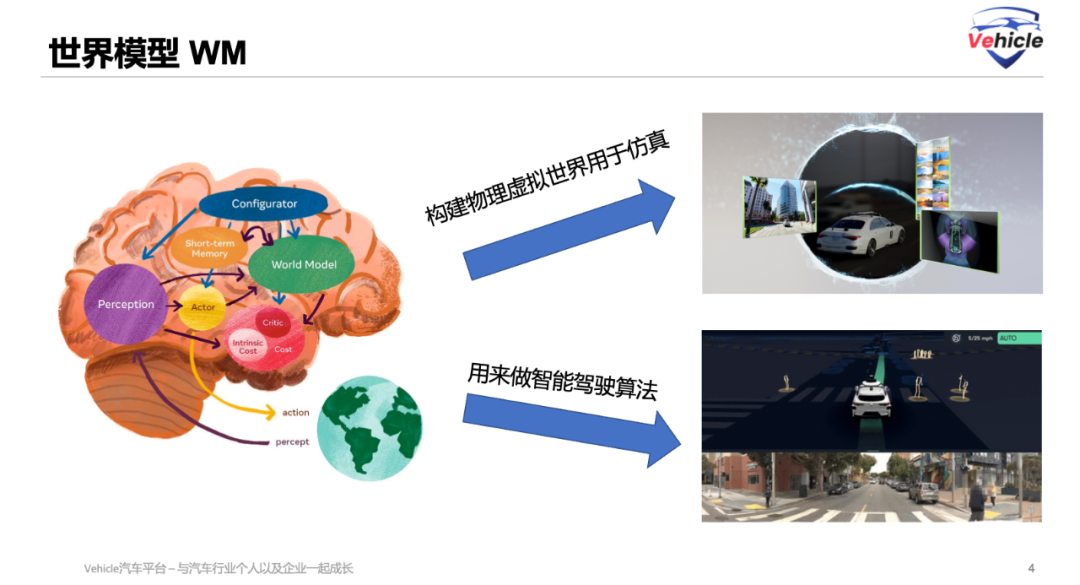

世界模型,本文中特斯拉和蔚来的NWM分别代表了世界模型的两大作用:一是构建物理虚拟世界用于仿真;二就是类似基础模型用于智能驾驶算法。

其实,这两个词都是为了方便宣传和理解。它们的相同点都是通识大模型,能理解人类物理世界,并具备推理能力;不同点只是应用和角度不一样罢了。

最后纵观自动驾驶技术的发展历程,我们清晰地看到了从模块化设计的工程化探索,到端到端(E2E)学习的集成化突破,再到如今视觉-语言-动作(VLA)模型所代表的具身智能新范式。当前,我们正处于 VLA技术从实验室走向量产的早期阶段,算力需求和推理延迟是亟待解决的实际问题。然而,随着英伟达等芯片厂商提供更强大的边缘计算能力,以及蔚来、理想、小鹏等厂商的积极自研大算力芯片和探索,基于大语言模型的VLA有望成为下一代智能驾驶的核心驱动力,真正将自动驾驶汽车打造成为我们专属的“AI司机”。

自动驾驶视觉-语言-动作模型综述ppt版本和pdf版本- 江思聪1 *、黄子林4 *、钱康安2 *、罗子昂2、朱天泽2、钟阳3、唐一红1、孔梦琳1、王云龙2、焦斯文3、叶浩 3 、盛子豪4、赵新2、托普温2 、郑 富2、陈斯凯4、 Kun Jiang 2 , 6 , Diiange Yang 2 , 6 , Seongjin Choi 5 , Lijun Sun 1 1加拿大麦吉尔大学 2中国清华大学 3小米集团 4美国威斯康星大学麦迪逊分校 5美国明尼苏达大学双城分校 6清华大学智能绿色汽车与出行国家重点实验室我是PG电子新手,有没有简单的入门指南?